北京2024年1月18日 /美通社/ -- 近日,模型源2.0开源大模型与LLaMA-Factory框架完成全面适配,适配用户通过LLaMA-Factory,模型即可快捷、适配高效地对不同参数规模的模型源2.0基础模型进行全量微调及高效微调,轻松实现专属大模型。适配

LLM(大语言模型)微调,是适配指在大模型的基础上,针对特定任务或领域进行调整和优化,模型以提升模型的适配性能和表现,有效的模型微调方案与工具也正是解决基础大模型落地私有领域的一大利器。基于开源大模型的适配微调,不仅可以提升LLM对于指令的模型遵循能力,也能通过行业知识的适配引入,来提升LLM在专业领域的模型知识和能力。

当前,业界已经基于LLM开发及实践出了众多的微调方法,如指令微调、基于人类反馈的强化学习(RLHF,Reinforcement Learning from Human Feedback)、直接偏好优化(DPO,Direct Preference Optimization)等。以高效微调(PEFT,Parameter-Efficient Fine-Tuning)方案为例,可有效解决内存和计算资源的制约,通过LoRA、QLoRA等高效微调技术,在单张GPU上完成千亿参数的微调训练。因此,一个能够实现上述功能的简洁、高效且易用的微调框架正是开展LLM微调工作的最佳抓手。

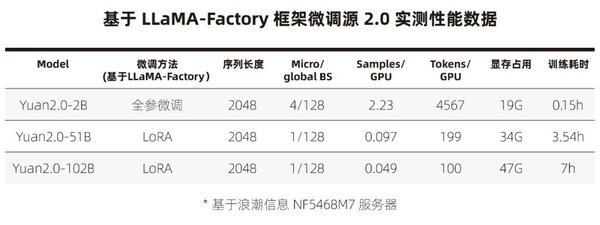

LLaMA-Factory是零隙智能(SeamLessAI)开源的低代码大模型训练框架,旨在为开发者提供可视化训练、推理平台及一键配置模型训练。基于LLaMA-Factory, 用户可轻松选择业界最全面的微调方法和优化技术,通过使用私域数据,或是LLaMA-Factory内置的中文数据集(GPT-4优化后的alpaca中文数据集、ShareGPT数据集和llama-factory提供的模型认知数据集),对源2.0进行轻松微调,基于有限算力完成领域大模型的定制开发。实测数据显示,在一台搭载8颗GPU的主流AI服务器NF5468M7,7小时内即可实现千亿模型(Yuan2.0- 102B)的高效指令微调,10分钟即可完成Yuan2.0-2B参数的指令微调,轻松实现即调即用。

Step by Step

单机即可实现千亿参数模型微调

GitHub项目地址:

https://github.com/IEIT-Yuan/Yuan-2.0/blob/main/docs/Yuan2_llama-factory.md

>友情链接: 国际EPD体系CEO拜访TÜV莱茵北京公司,推动EPD中国体系建设首获殊荣 友邦人寿荣膺HR Asia"2023亚洲最佳企业雇主"等三项大奖猫咪寄生虫自测工具正式上线,博来恩全面升级引领专驱新纪元爆冷!郑钦文不敌西格蒙德,止步澳网公开赛第二轮走进日间中心,探索青少年心理泰国优质朗姆酒品牌RUANG KHAO SIAM SAPPHIRE全球首发 融合东西方风味美味韩食,与“沪”共“进”美通社助力企业扩大亚太市场影响力,2024年再赢众多内容合作新伙伴猫咪寄生虫自测工具正式上线,博来恩全面升级引领专驱新纪元创新、合作、发展!勃林格殷格翰参展第六届中国国际进口博览会成绩单出炉猫咪寄生虫自测工具正式上线,博来恩全面升级引领专驱新纪元千亿长护市场即将爆发,长护服务迎来“九万里”时刻第三季度三品牌精益增进,君澜度假圈再添世界文化遗产旅游目的地代表通道|廖石秀:以油茶产业探索石漠化治理 激活农业现代化发展“新引擎”中国电源学会40周年庆典 台达创办人郑崇华获颁科学技术奖 "杰出贡献奖"